制造一个键盘大的芯片要面临哪些挑战?

时间:2019-08-23 | 栏目:台式机 | 点击:次

目前,最大的计算机芯片通常可以放在手掌里,有些小的可以放在指尖上。芯片越来越小似乎是行业整体发展趋势和普遍理念。现在,硅谷的一家创业公司Cerebras正在挑战这一观念。

本周一,该公司公布了据称是有史以来最大的计算机芯片。它和餐盘一样大——大约是一块普通芯片的100倍——几乎不能放在人的大腿上。开发该芯片的工程师相信它可以用于大型数据中心,并有助于加速人工智能(AI)的发展,从自动驾驶汽车到亚马逊的Alexa,都可以因它的出现而受益。

许多公司正在为AI制造新的芯片,包括传统的芯片制造商,如英特尔(Intel)和高通(Qualcomm),以及美国、英国和中国的其他初创企业。

谷歌已经制造出了这种芯片,并将其应用于多个人工智能项目中,包括谷歌助手(google assistant)和谷歌翻译(google translate),后者可以识别安卓手机上的语音命令,并将一种语言翻译成另一种语言。

Cerebras首席执行官兼创始人Andrew Feldman称,“这个领域的增长非常惊人。"他是一位芯片行业资深人士,此前曾将一家公司卖给芯片巨头AMD。

新AI系统依赖于神经网络。这些复杂的数学系统松散地基于神经元网络,可以通过分析大量数据来学习任务。例如,通过精确定位数千只猫照片中的模式,神经网络可以学会识别猫。

这需要一种特殊的计算能力。如今,大多数公司在GPU的帮助下分析数据。这些芯片最初是为游戏和其他软件渲染图像而设计的,但它们也擅长运行驱动神经网络的数学运算。

大约六年前,随着谷歌、Facebook和微软等科技巨头在人工智能领域加大投入,它们开始大量购买英伟达的GPU。在截至2016年夏季的一年里,英伟达在美国的平均销售额为1.43亿美元,是前一年的两倍多。但是这些公司想要更多的处理能力。

谷歌专门为神经网络(Tensor Processing Unit,简称TPU)开发了一种芯片,其他几家芯片制造商也在追求同样的目标。AI系统与许多芯片协同工作。麻烦的是,在芯片之间移动大块数据可能会很慢,并且会限制芯片分析该信息的速度。加州大学洛杉矶分校专门从事人工智能芯片设计的教授Subramanian Iyer表示,“将所有这些芯片连接在一起,实际上会减慢它们的速度,并消耗大量能量。”硬件制造商正在探索许多不同的选择。有些人试图拓宽芯片之间的管道。

Cerebras,一家仅有3年历史、资金超过2亿美元的公司,已经采取了一种新颖的方法。这个想法是把所有的数据保存在一个巨大的芯片上,这样系统就可以更快地运行。

使用一个大的芯片是非常困难的。计算机芯片通常安装在直径约12英寸的圆形硅片上。每个晶圆片通常包含约100个芯片。许多这样的芯片,当从晶圆片中取出时,就会被扔掉,再也不用了。蚀刻电路进入硅是一个如此复杂的过程,制造商无法消除缺陷。有些电路不起作用。这是芯片制造商保持芯片尽量小的原因之一 - 减少错误的空间,因此他们不必抛弃那么多。

Cerebras公司表示,他们已经制造了一块晶圆大小的芯片。其他人也尝试过这种方法,最著名的是一家名为Trilogy的初创企业,由著名的IBM芯片工程师Gene Amdahl于1980年创立。尽管获得了2.3亿多美元的资金支持,但最终还是觉得这个任务太难了,五年后就倒闭了。

Cerebras计划下个月开始向少数客户发货硬件,Feldman说,这种芯片训练人工智能系统的速度可以比现有硬件快100到1000倍。他和他的工程师们已经把他们的巨型芯片分成了更小的部分,或者说是核心,因为他们知道有些核心是不能工作的。该公司的硬件存在重大问题。费尔德曼有关芯片性能的说法尚未得到证实,他也没有透露芯片的价格。价格将取决于Cerebras及其制造合作伙伴台积电(TSMC)生产该芯片的效率。

台积电的高级副总裁BradPaulsen表示,这一过程“需要更多劳动力”。一个如此大的芯片会消耗大量的能量,这意味着保持它的冷却将是困难和昂贵的。换句话说,构建芯片只是任务的一部分。“这对我们来说是一个挑战,”鲍尔森说。“这对他们来说也是。”Cerebras计划将该芯片作为一个更大机器的一部分出售,该机器包括用冷冻液体冷却硅的精密设备。这与大型科技公司和政府机构习惯于合作的方式完全不同。

“并不是说人们没能制造出这种芯片,”伊利诺伊大学(University of Illinois)教授Rakesh Kumar说,他也在为人工智能研究大型芯片,“问题是他们没能制造出一种商业上可行的芯片。”直到今天,新一代的隐形硅片公司Cerebras一直在寻求让训练成为一种深度学习模式,就像从亚马逊(Amazon)购买牙膏一样快。

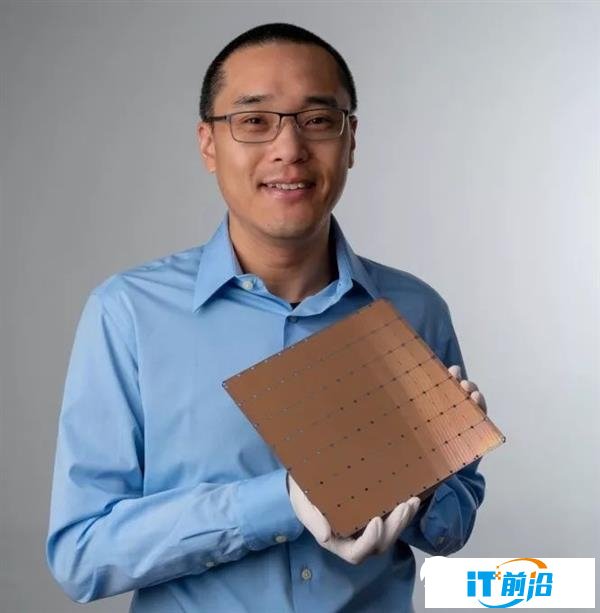

经过近三年的静悄悄的研发,Cerebras今天推出了它的新芯片——这是一款出色的芯片。“晶圆级引擎”是1.2万亿个晶体管(有史以来最多),46,225平方毫米(有史以来最大),包括18千兆字节的片上存储器(目前市场上最多的芯片)和40万个处理器核心(估计是最高级的)。

图:Cerebras的晶片级引擎比典型的Mac键盘更大

图:Cerebras的晶片级引擎比典型的Mac键盘更大

在斯坦福大学(StanfordUniversity)的Hot Chips大会上,它引起了很大的轰动。Hot Chips大会是硅行业为产品介绍和路线图而举办的大型会议之一,与会者中有不同级别的“ooh”和“aah”。你可以从《财富》杂志的Tiernan Ray那里了解更多关于这种芯片的信息,也可以阅读Cerebras的白皮书。今天下午,我与公司创始人兼首席执行官AndrewFeldman坐下来,讨论了他手下的173名工程师在过去几年里用Benchmark等公司1.12亿美元的风投资金,在这条街上悄悄做了什么。

做大意味着挑战

首先,简要介绍一下为手机和电脑供电的芯片是如何制造的。像台积电这样的晶圆代工厂采用标准尺寸的硅片,利用光将晶体管蚀刻到晶圆上,然后将它们分割成单独的芯片。晶圆是圆形的,芯片是正方形的,因此将圆细分成清晰的单个芯片阵列涉及到一些基本的几何知识。光刻工艺的一大挑战是,错误可能会渗透到制造过程中,需要大量的测试来验证质量,并迫使晶圆厂扔掉性能不佳的芯片。芯片越小、越紧凑,单个芯片失效的可能性就越小,晶圆厂的产量也就越高。高收益等于高利润。

Cerebras提出了在单个晶圆片上蚀刻一系列单独芯片的想法,而不是仅仅使用整个晶圆片本身作为一个巨大的芯片。这使得所有这些单独的核心可以彼此直接连接——极大地加快了用于深度学习算法的关键反馈循环——但这是以巨大的制造和设计挑战为代价来创建和管理这些芯片的。

Cerebras的技术架构和设计由联合创始人Sean Lie领导。Feldman和Lie之前合作创办了一家名为SeaMicro的公司,2012年该公司以3.34亿美元的价格卖给了AMD。

根据Feldman的说法,团队遇到的第一个挑战是处理“划线”之间的通信。虽然Cerebras芯片包含一个完整的晶圆,但今天的光刻设备仍然必须像在硅片上蚀刻单个芯片一样工作。因此,该公司不得不发明新技术,让这些单独的芯片能够在整个晶圆上相互通信。在与台积电合作中,他们不仅发明了新的通信通道,而且还不得不编写新的软件来处理拥有超过万亿晶体管的芯片。

第二个挑战是良率。当一个芯片覆盖整个硅晶片时,晶片蚀刻上的任何一个缺陷都可能导致整个芯片无法运作。这是整个晶圆技术几十年来的难题:根据物理定律,几乎不可能以完美的精确度反复蚀刻一万亿个晶体管。Cerebras通过在芯片中添加额外的核心来解决这个问题,当核心附近的晶片出现错误时,这些核心将被用作备份。

Feldman向我解释说:“你只需要持有占总量1%,1.5%的额外的核心。” 留下额外的核心使芯片基本上可以自我修复,绕过光刻错误,使整个晶片硅芯片可行。

进入芯片设计的未知领域

最初的两个挑战——芯片之间的划线通信和处理良率——已经困扰了芯片设计师几十年。但它们都是已知的问题,Feldman说,通过使用现代工具重新处理它们,它们实际上更容易解决预期的问题。不过,他把这项挑战比作攀登珠穆朗玛峰。“就像第一批人没能登上珠穆朗玛峰一样,他们说,‘该死,第一部分真的很难。’然后下一组人过来说: ‘那算什么。最后一百码,才是个问题。”

事实上,根据Feldman的说法,对Cerebras来说,最困难的挑战是接下来的三个,因为没有其他芯片设计师能通过划线通信来找出接下来发生了什么。芯片在运行中会变得非常热,但不同的材料会以不同的速度膨胀。这意味着连接芯片和主板的连接器也需要以同样的速度进行热膨胀,以免两者之间产生裂缝。Feldman说:“你如何找到一个可以承受这种压力的连接器?以前从来没有人这样做过,所以我们需要发明一种材料。因此,我们拥有材料科学博士,我们必须发明一种材料,能够化解其中的一些差异。”一旦芯片被制造出来,它就需要经过测试和封装,然后运送给原始设备制造商(OEMs),由原始设备制造商将芯片添加到终端客户(无论是数据中心还是消费者笔记本电脑)使用的产品中。

不过,也存在一个挑战:市场上绝对没有任何东西是为处理整个晶圆芯片而设计的。

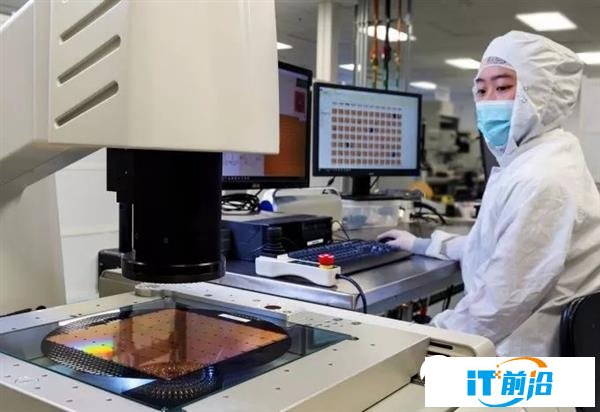

图:Cerebras设计了自己的测试和封装系统来处理它的芯片

图:Cerebras设计了自己的测试和封装系统来处理它的芯片

现阶段,没有人有这么大的印刷电路板、连接器、冷却盘,也没有软件和工具来调试它们。Feldman解释说。“所以我们设计了整个生产流程,因为从来没有人这样做过。“Cerebras的技术不仅仅是它所销售的芯片,它还包括所有相关的机械设备,这些机械设备是用来制造和封装这些芯片的。Cerebras的芯片使用15千瓦的功率运行,这对于单个芯片来说是一个巨大的功耗,尽管与现代大小的AI集群相当。所有这些功能也需要冷却,Cerebras必须设计一种新方法来为这么大的芯片提供这两种功能。它基本上是通过将芯片翻转过来来解决这个问题的,Feldman称之为“使用z维度”。

“我们的想法是,与传统的在芯片上横向移动电源和冷却设备不同,电源和冷却设备在芯片上的所有点都是垂直传输的,以确保两者的访问是均匀一致的。”因此,这就是该公司在过去几年中日以继夜努力解决的三个挑战——热膨胀、封装和电源/冷却。

从理论到现实

Cerebras有一个演示芯片(它和我们的头差不多大),据报道,它已经开始向客户交付原型。然而,与所有新芯片一样,最大的挑战是扩大生产,以满足客户的需求。

对于Cerebras来说,这种情况有点不寻常。由于它在一个晶圆上融入了如此多的计算能力,客户不必购买数十或数百个芯片并将它们拼接在一起来创建一个计算集群。相反,他们可能只需要少量的Cerebras芯片来满足他们的深度学习需求。该公司的下一个阶段是实现规模化,并确保其芯片的稳定交付。该公司将芯片封装为一个完整的系统“设备”,其中还包括其专有的冷却技术。预计在未来几个月会听到更多关于Cerebras技术的细节,特别是在关于未来深度学习处理工作流程的争论不断升温之际。